构建 MLC LLM 并打包 Android 应用:大语言模型Android本地部署完整指南

本文介绍如何在 Ubuntu 系统下构建并配置 MLC LLM,完成模型打包,并通过 Android Studio 将其集成到移动端应用中。您将学习从本地编译 MLC LLM、生成适用于 Android 的模型资源包,到在 Android Studio 中打开 MLCChat 项目、构建并导出可安装 APK 的完整端到端流程,实现大语言模型在移动设备上的本地部署与运行。

1

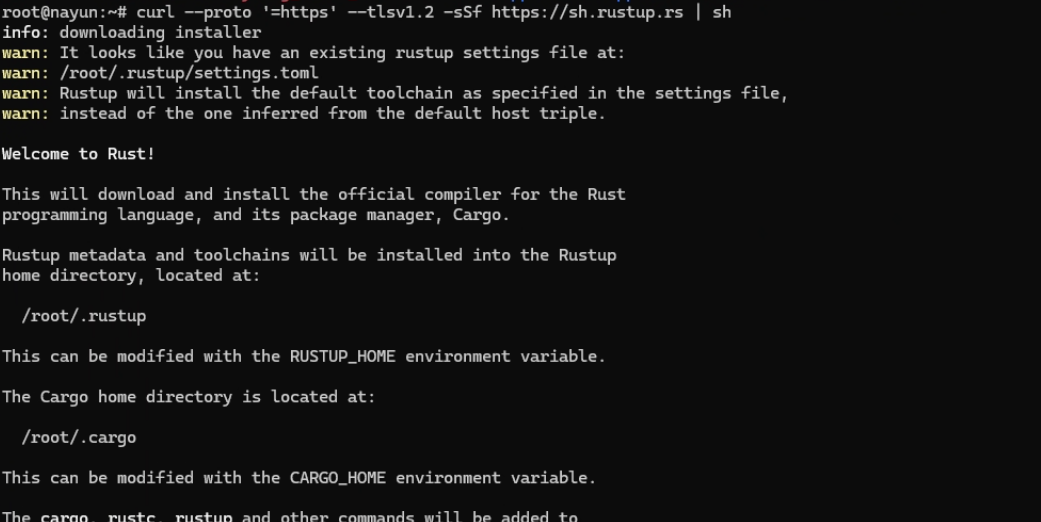

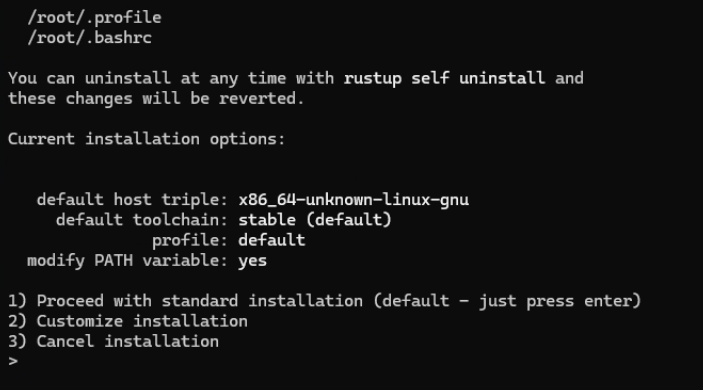

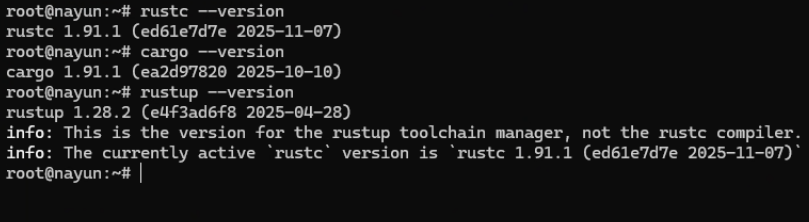

安装Rust

2

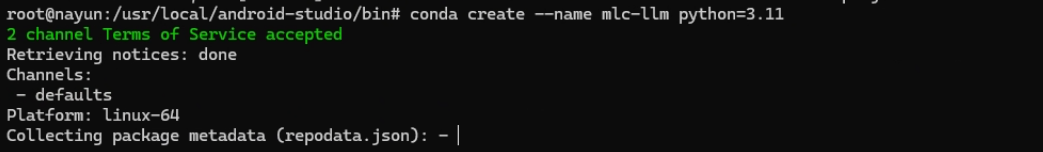

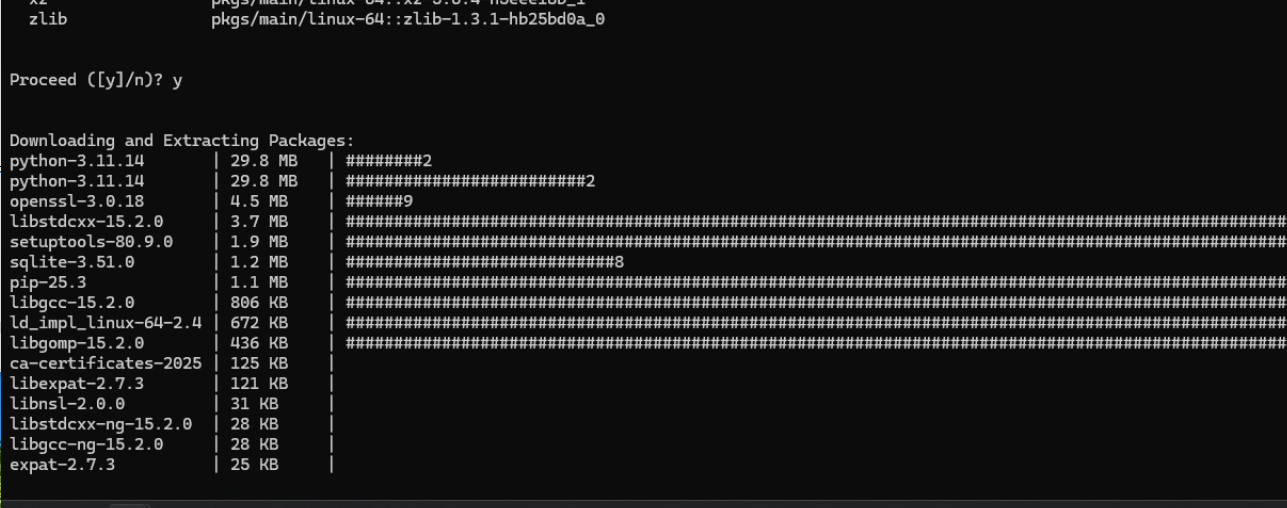

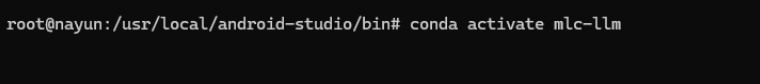

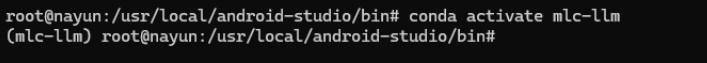

创建conda环境

3

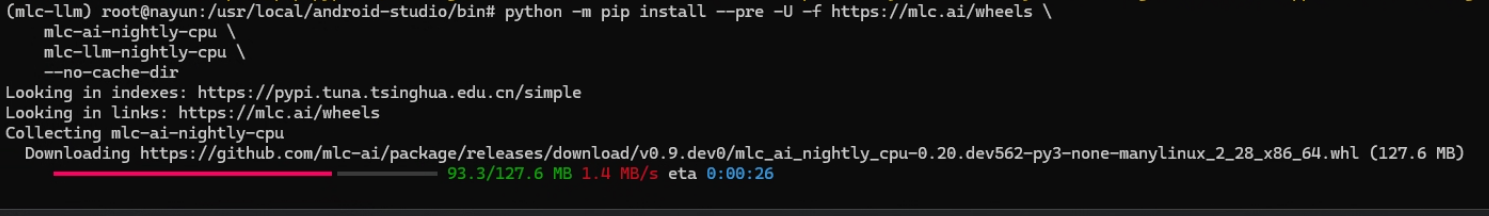

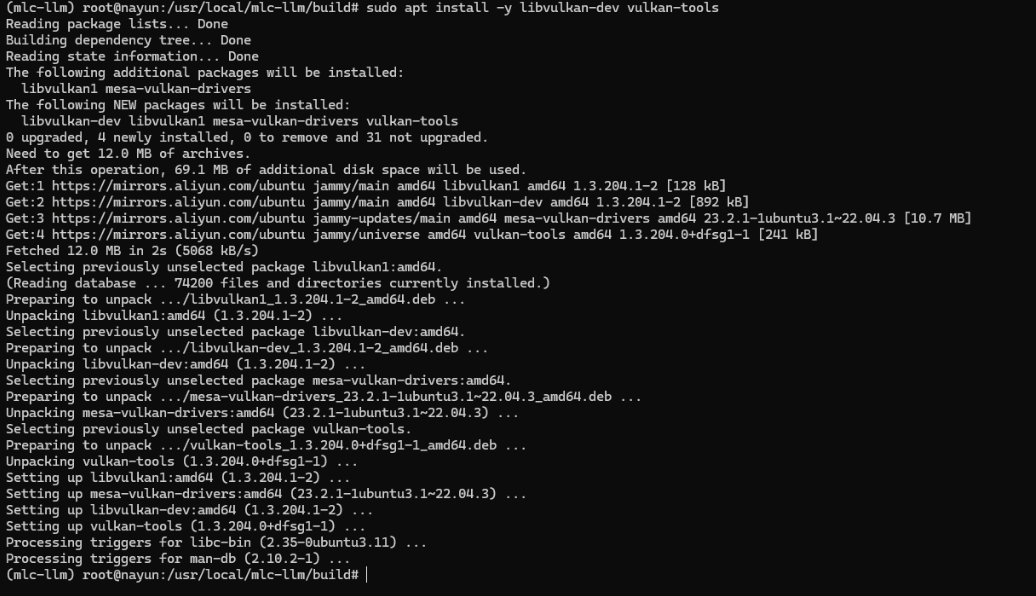

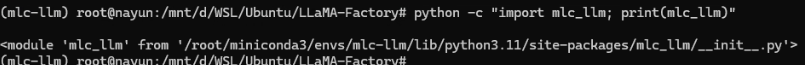

安装和验证mlc_llm

4

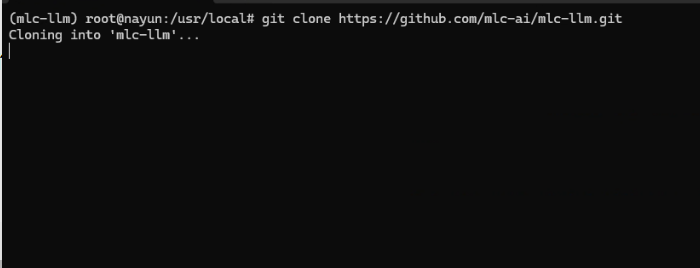

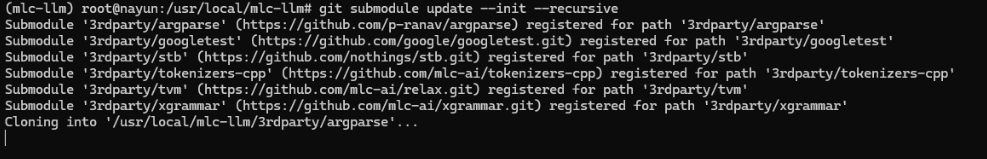

克隆mlc-llm

5

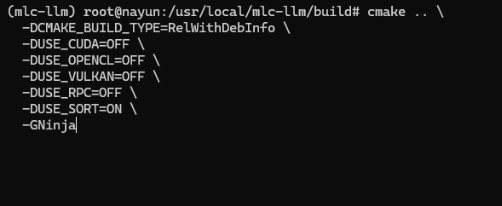

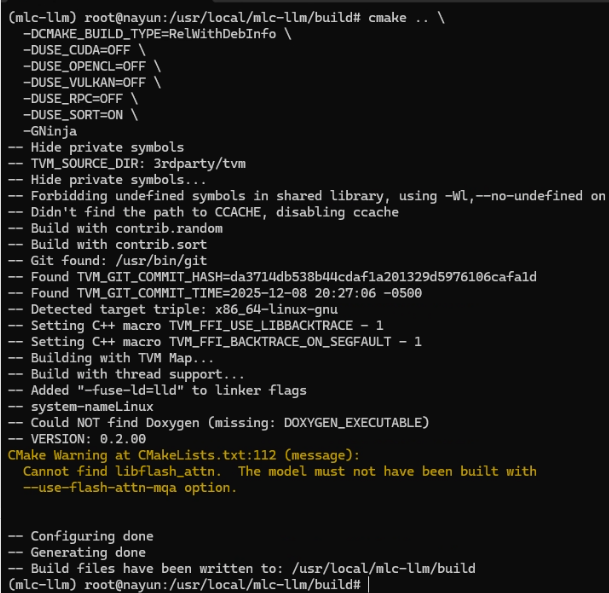

配置 CMake 并准备 CPU 构建

6

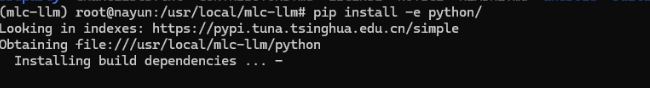

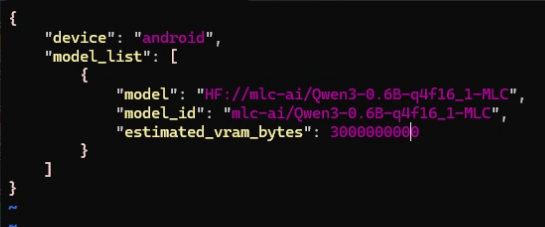

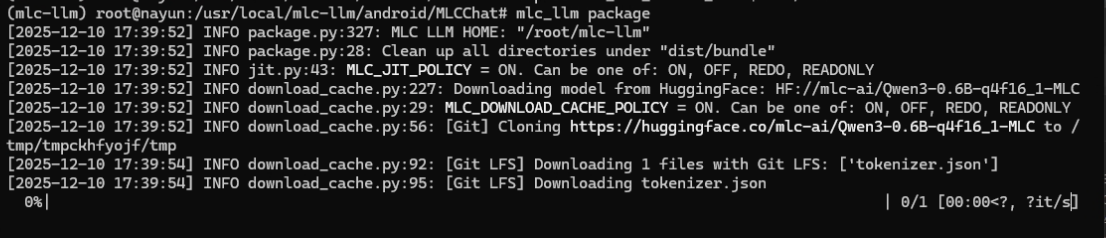

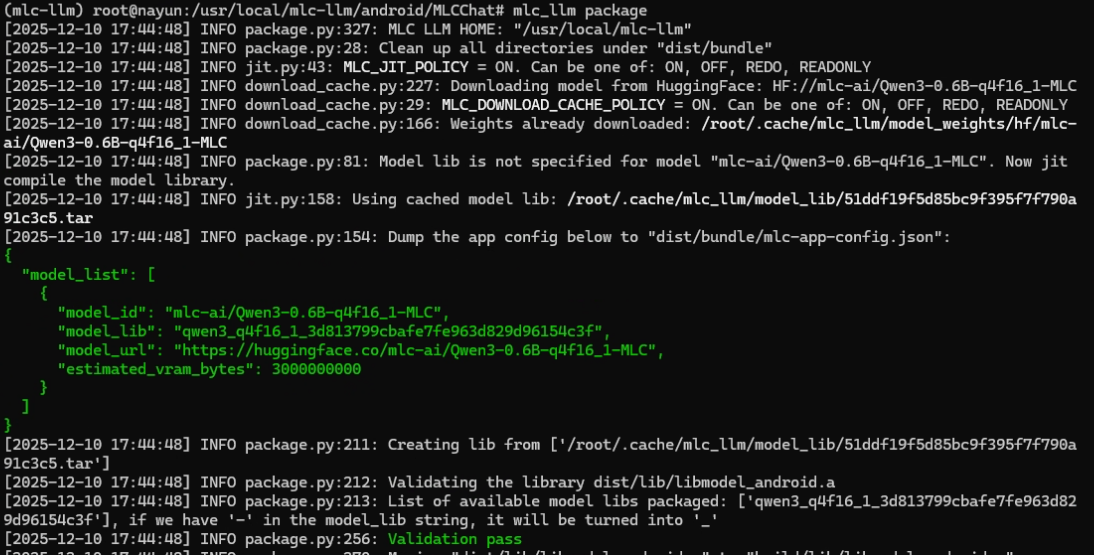

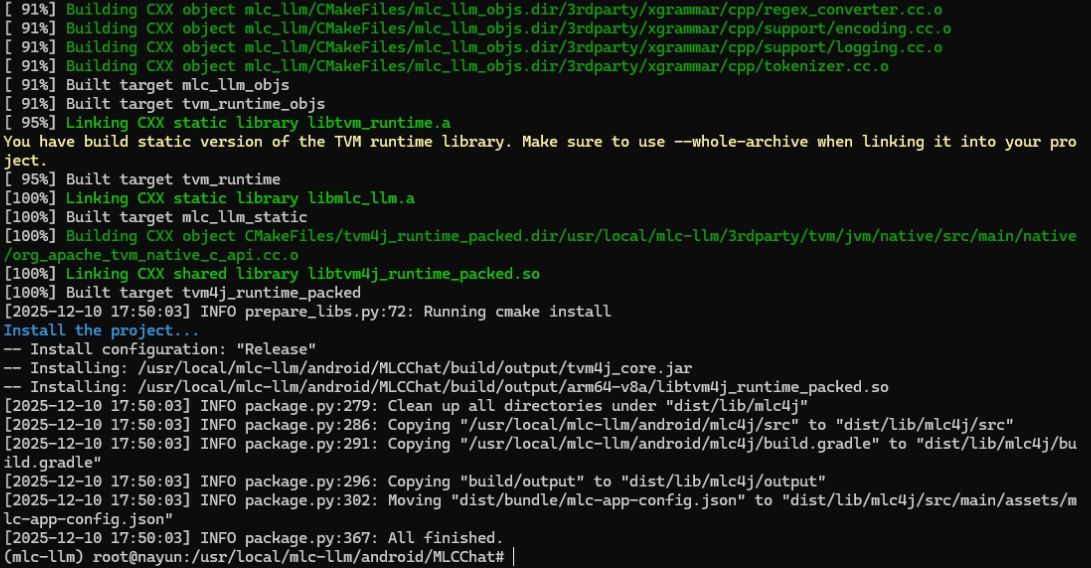

打包mlc-llm

7

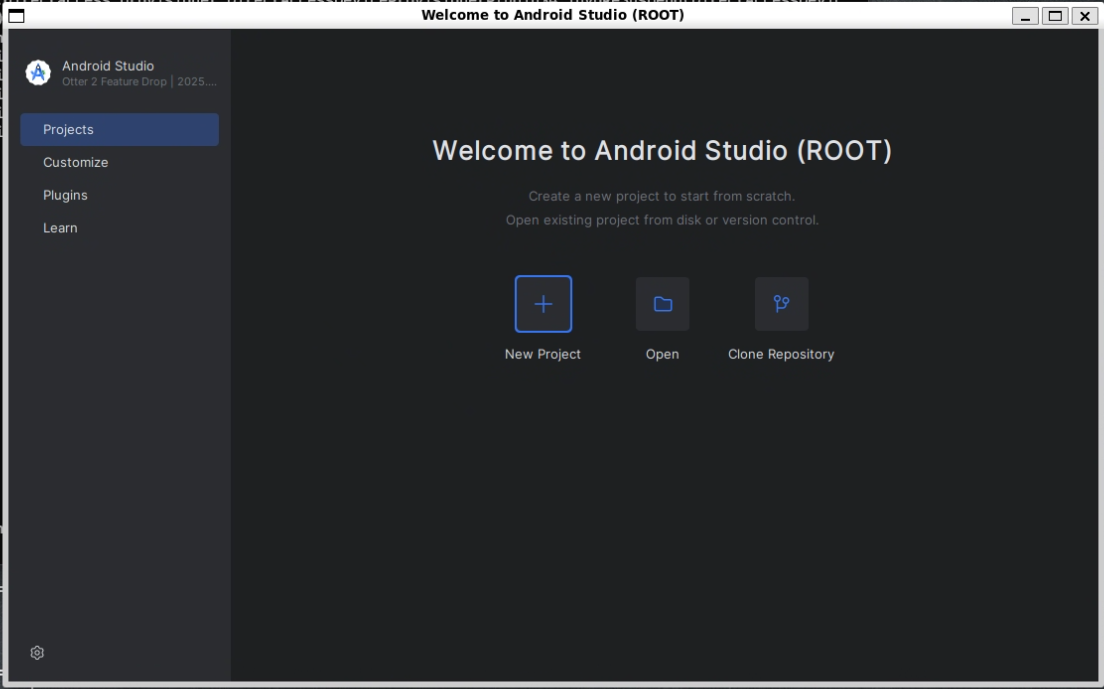

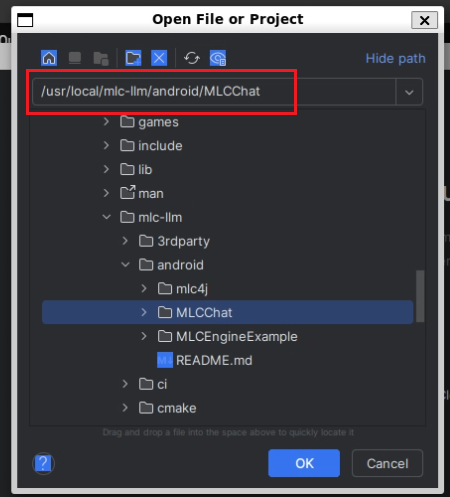

打开MLCCHAT项目

8

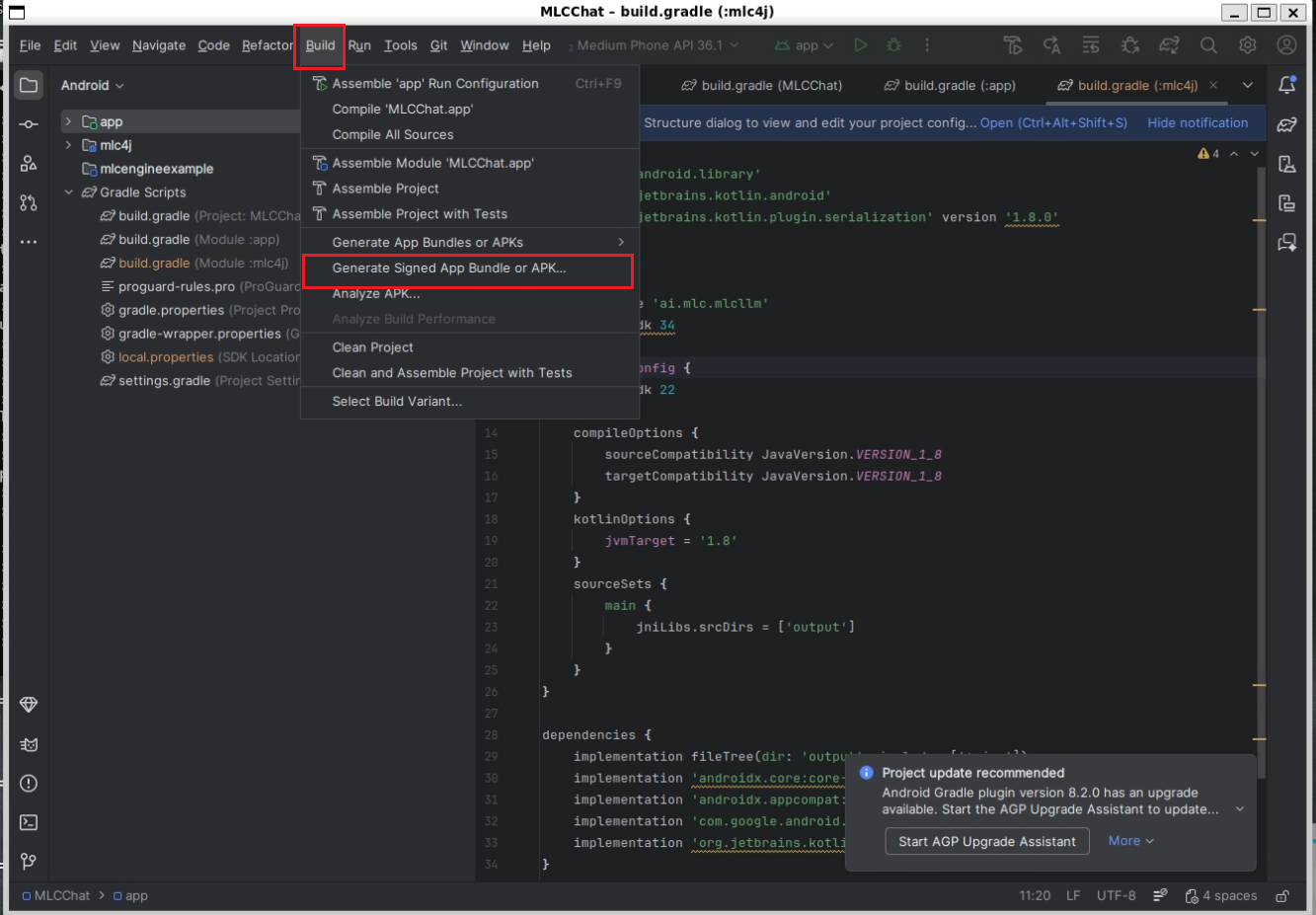

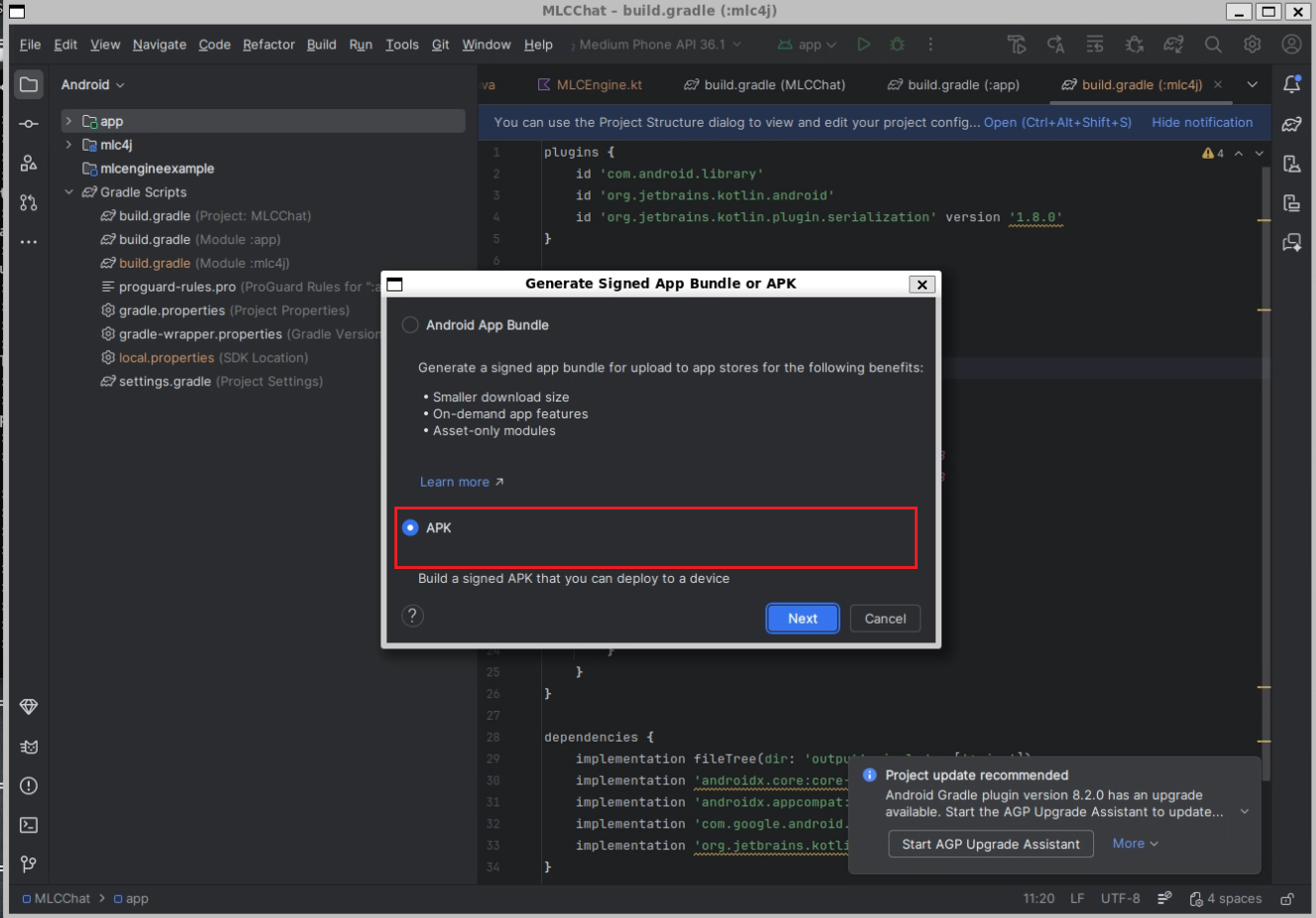

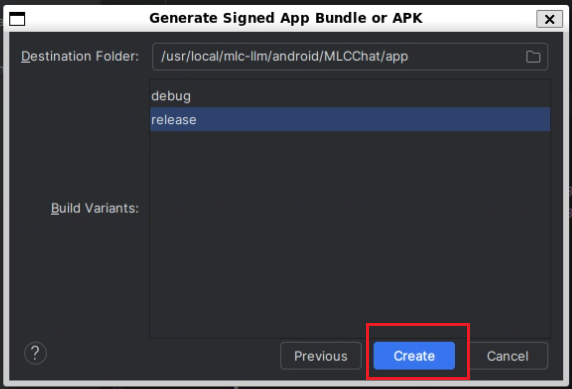

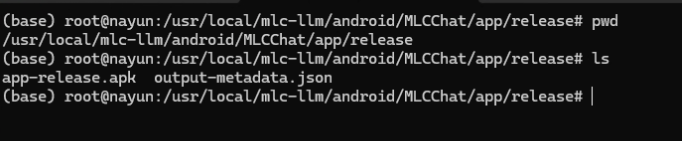

生成APP

0

0 0

0 0

0猜你喜欢

评论/提问(已发布 0 条)

0

0

qq空间

qq空间  微博

微博  复制链接

复制链接  分享

分享