大模型qwen3使用llama.cpp转换为gguf格式

为了在安卓设备上顺利运行Qwen3系列大模型,通常需要借助llama.cpp工具将原始模型转换为更适合移动端部署的GGUF格式。GGUF是一种轻量、高效的模型格式,支持在资源受限的设备上进行推理。通过这一转换流程,不仅可以减小模型体积,还能提升在手机端的加载速度与运行效率,从而实现本地化、低延迟的AI体验。

1

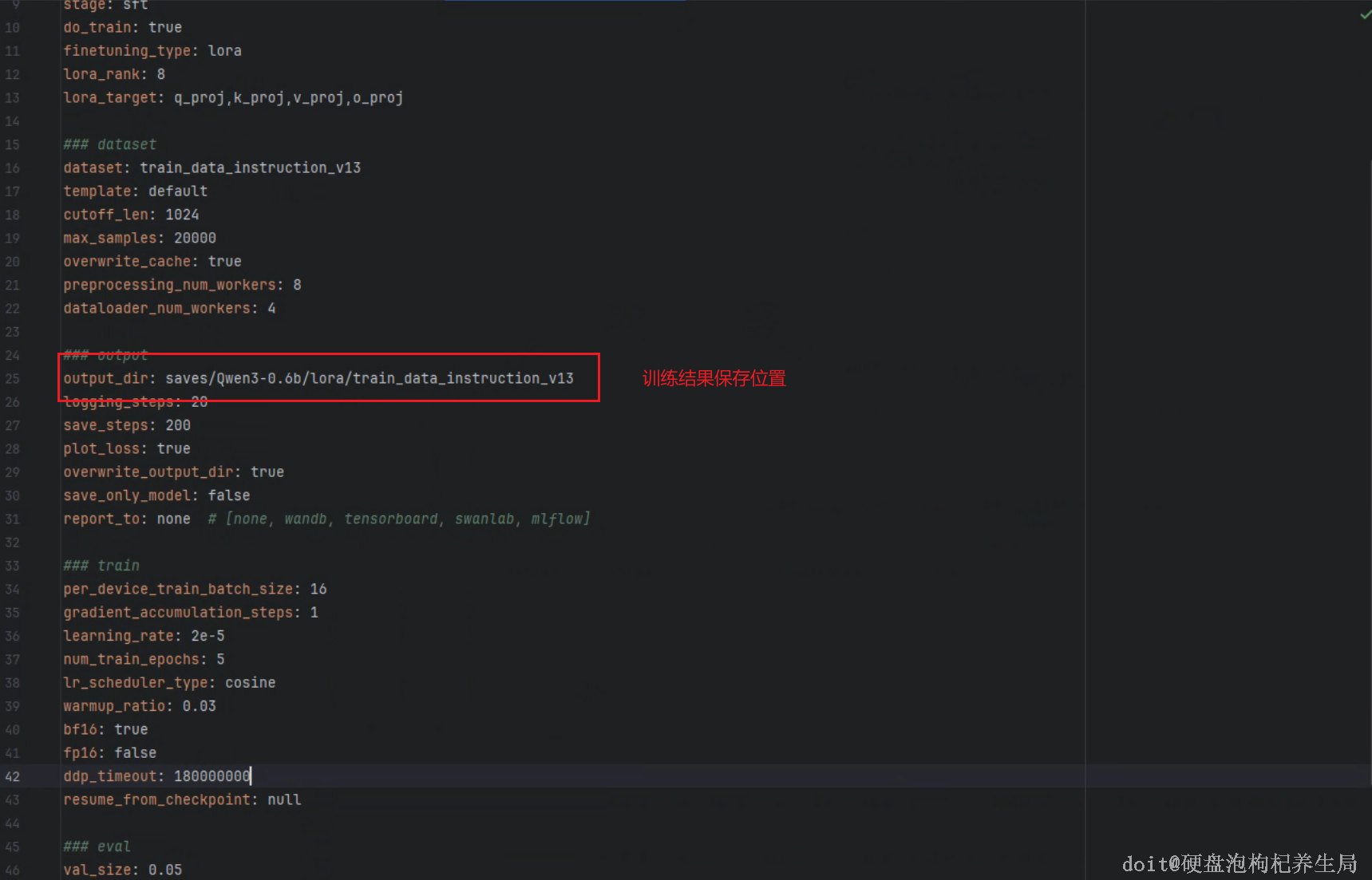

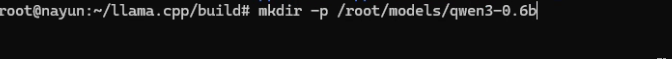

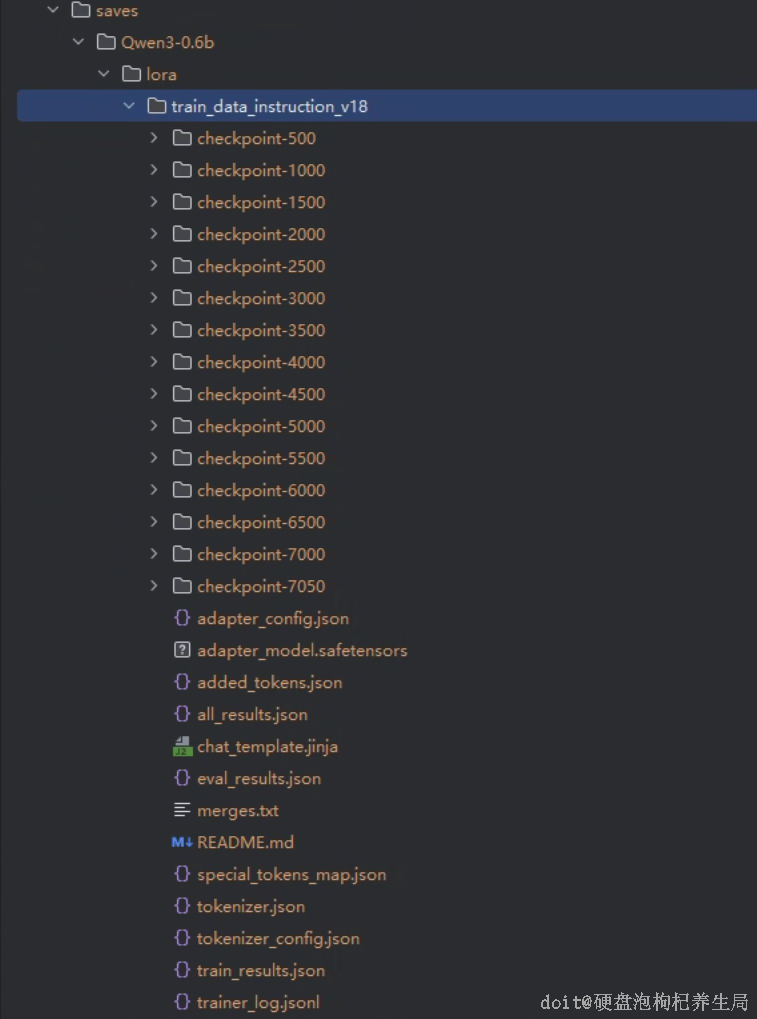

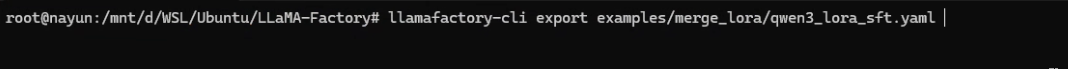

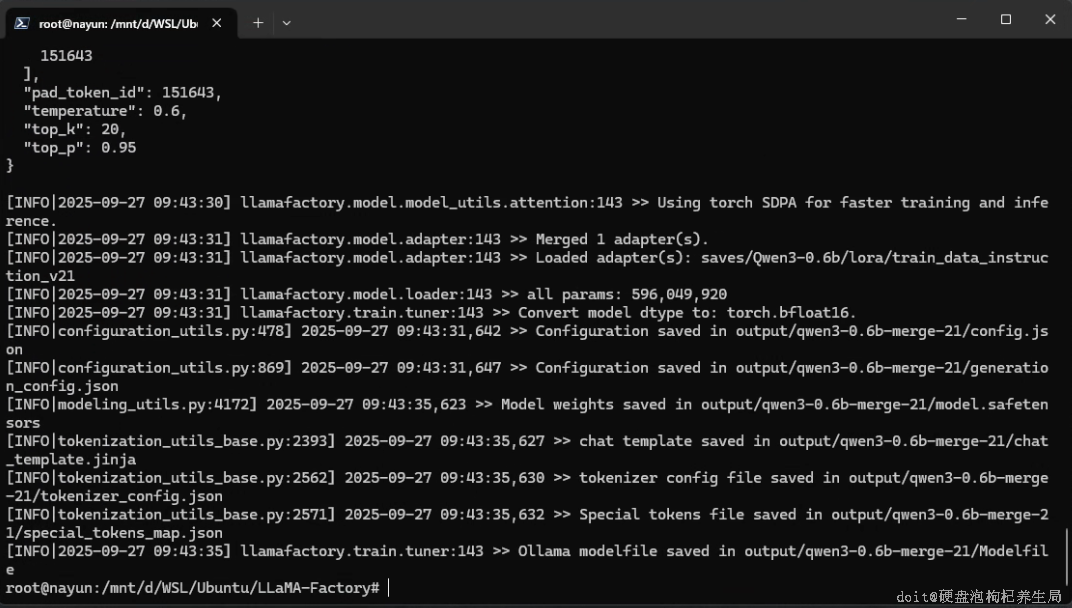

合并模型

2

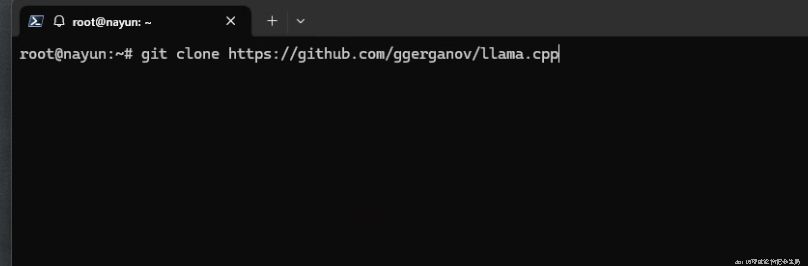

下载llama.cpp

3

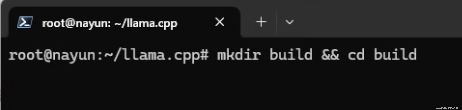

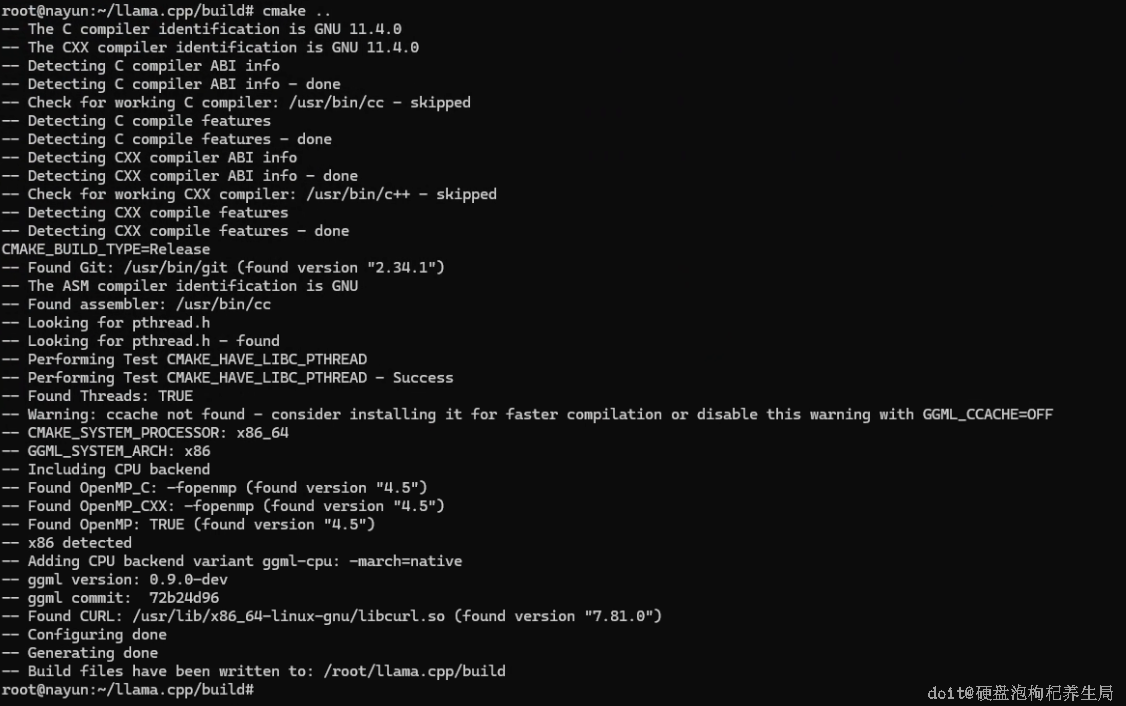

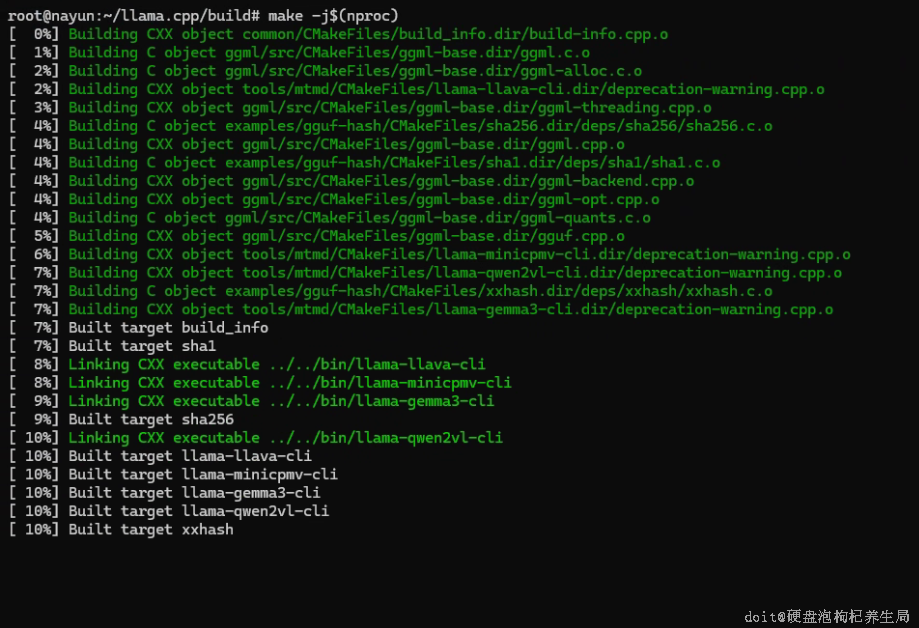

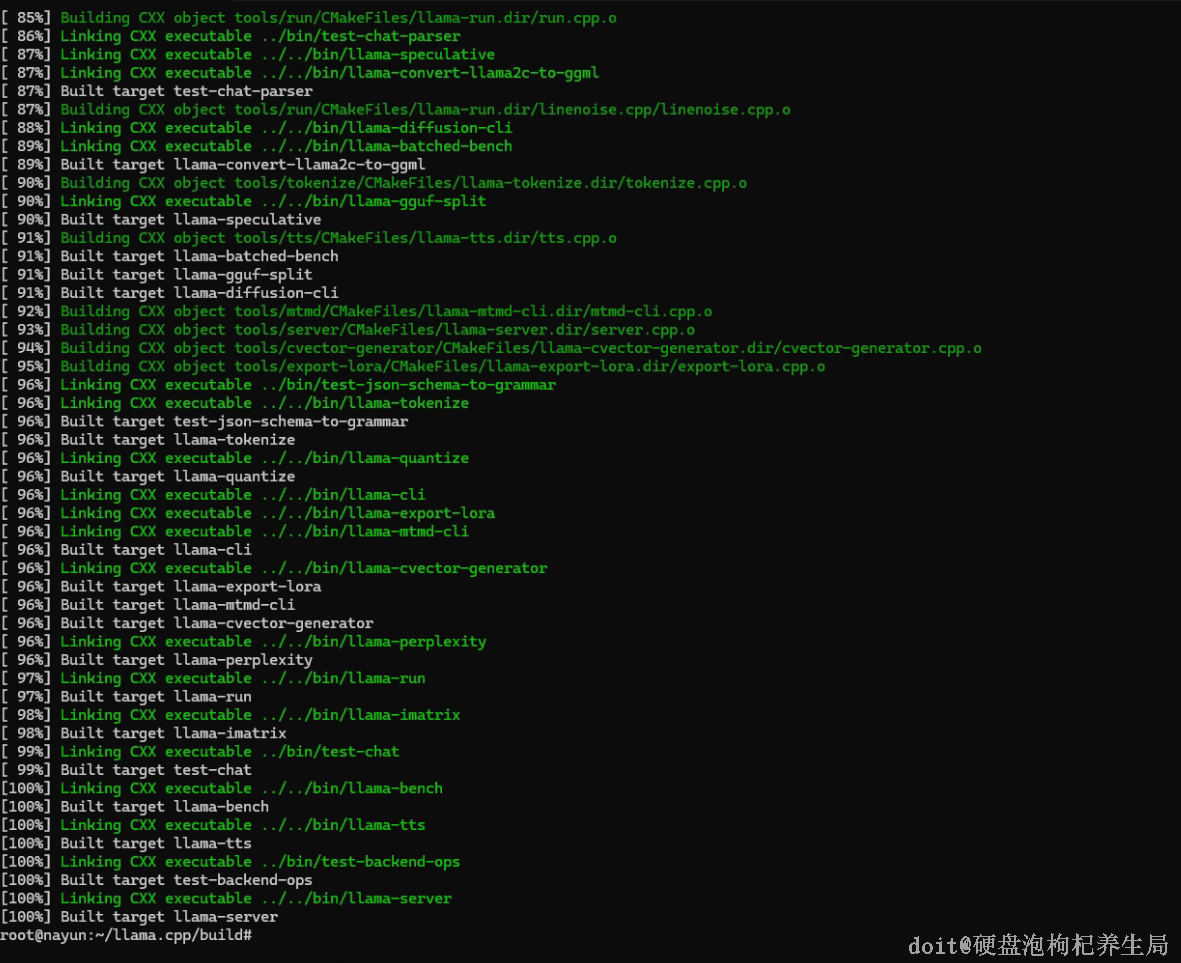

编译llama

4

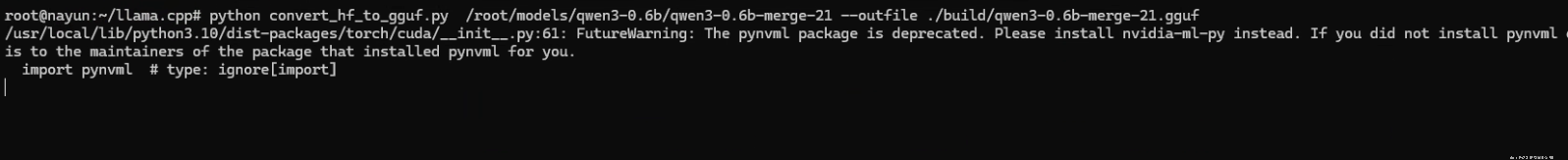

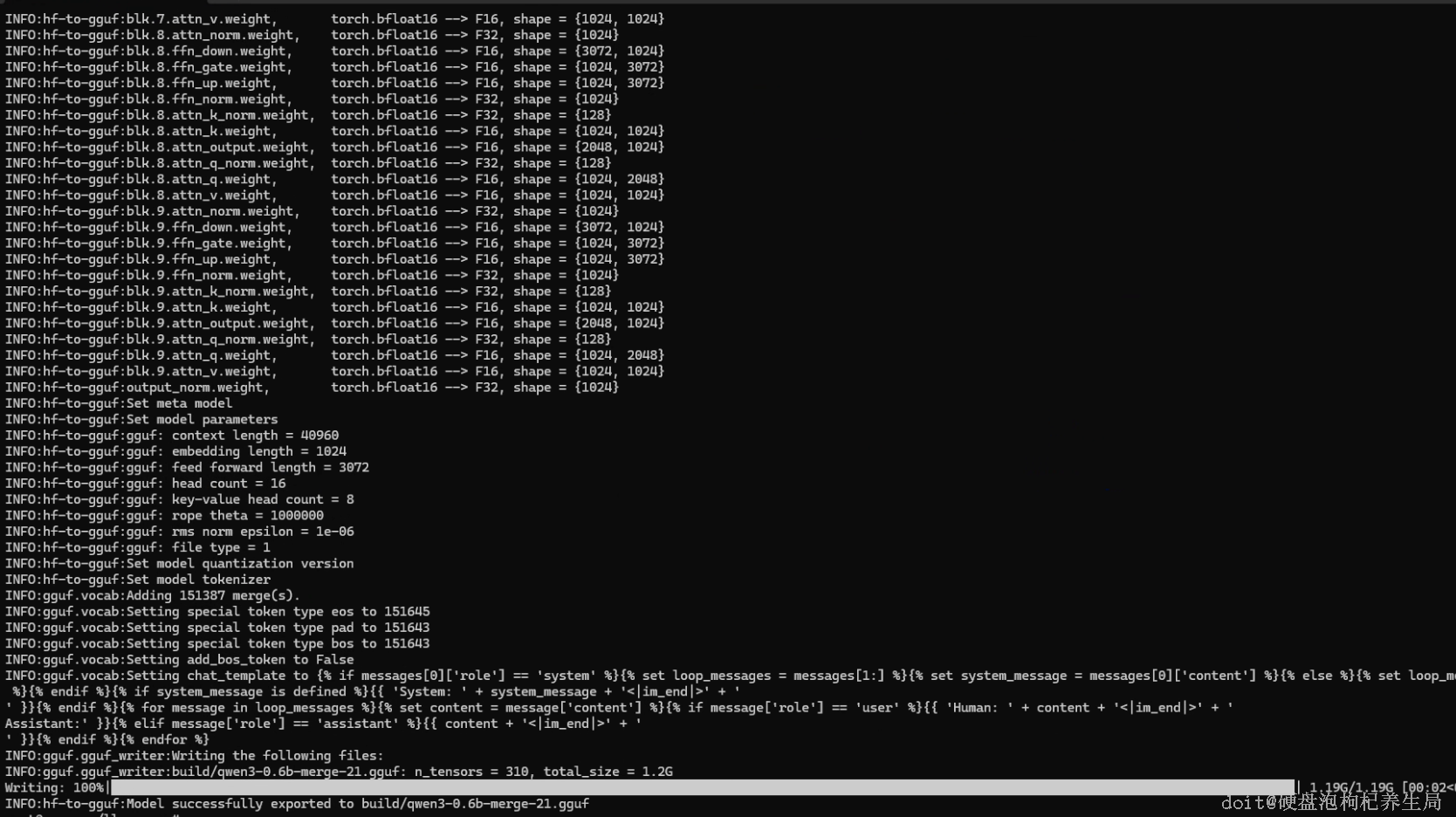

转换模型

5

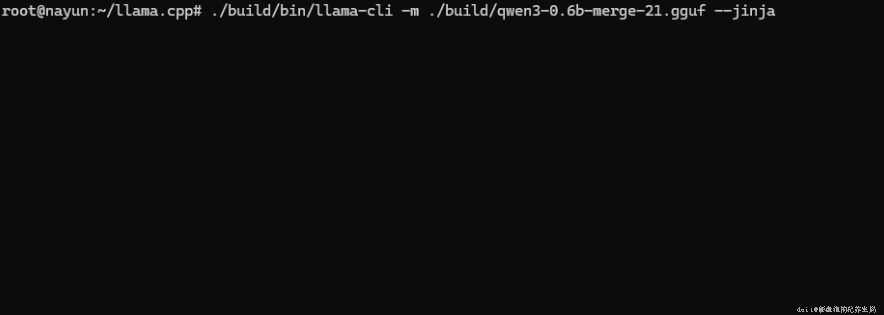

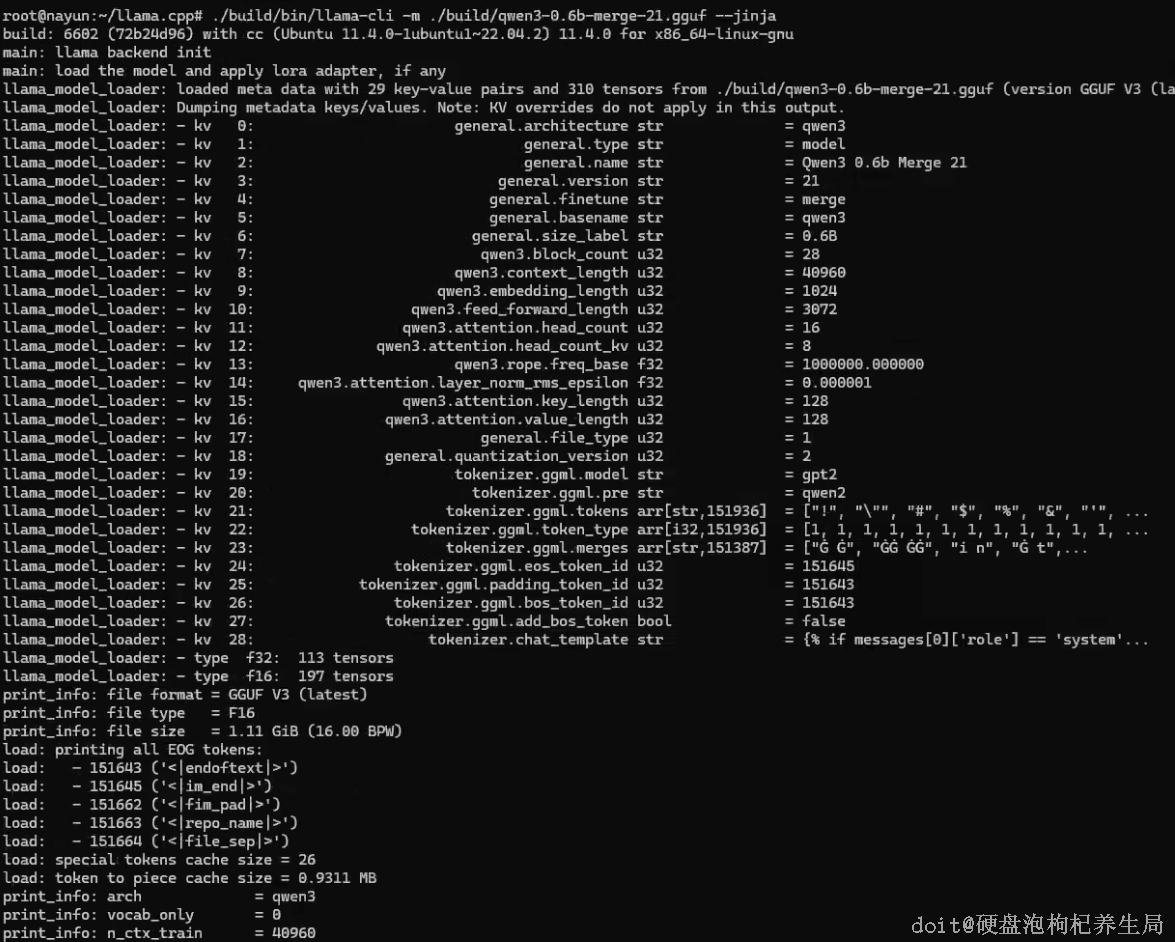

运行gguf文件

0

0 0

0 0

0猜你喜欢

评论/提问(已发布 0 条)

0

0

qq空间

qq空间  微博

微博  复制链接

复制链接  分享

分享